편향

최근에 판단을 해야하는 일들이 많아졌다. 나는 머릿속으로 이것저것 따지느라 판단을 빨리 하지 못하는 스타일이다.

그래서 순간적인 판단에는 좀 약한 편인데 이를 좀 훈련해보고자 판단의 프로세스를 정리해보고 있다.

아마 판단이 오래걸리는 까닭에는 판단의 기준이나 판단까지이어지는 생각하는 프로세스가 정립되어있지 않은 터일 것이다.

대게 순간적인 판단들이 필요할 상황은 보통 즉각적으로 액션이 바로 이어져야하는 상황들이다.

예컨대 잘못 들어간 주문처럼, 시간이 흘러버리면 더이상 액션을 할 수 없고, 판단 지연으로 초래된 리스크를 감당해야하는 상황들이 종종 있었다. 재밌게도 반대로는 판단 지연으로 인해 과소비를 막는 경우도 있기도 했다.

또 다른 이유로는 내 판단이 편향되지 않았는지를 자기검토 하는 과정에서 시간이 지체되기도 한다. 가벼운 일례로 주식을 매수/매도할지라던지 그런 상황에서 내가 더욱더 전문 애널리스트는 아니기에, 어떤 생각에 치우쳐져 판단하는 것이 아닌지, 어떤 판단이 옳은지 결정하기 어렵다. 혹은 다른 사람의 고민이나 사회적 이슈에 대한 이야기라던지. 그런 경우들이 떠오른다. 요즘에야 GPT 와 이것저것 경우를 따지지면 어느정도 도움은 되는데, 그 역시도 판단의 근거를 쉽게 찾는 도구일 뿐이지 결국 절정을 해야한다는것은 다름없기에 여전히 어렵다.

왜 좀처럼 크고 작은 편향으로 부터 벗어나기 어려운걸까? 뇌과학을 전공하진 않았지만, 뇌가 그렇게 설계되지 않았기 때문일 것 같다. 애초에 선택, 판단의 대다수는 인간이 만들어낸 선택지 안에서 벌어지는 것들이기에 판단을 위한 완벽히 이상적인 머신이 존재할 수 있을지도 의문이긴하다. 편향이 나쁜 현상이라기 보다는 생존을 위한 사고의 울타리를 벗어나지 않게 하기 위한 양치기 아닐까?

세상의 모든 변수를 고려해서 완벽한 시뮬레이션을 만들게 된다면 판단이 쉽겠지만, 현실적으로는 불가능하다. 복잡한 세상을 해석하기 위해서 우리는 적당한 변수와 역학의 패턴을 찾는다. 그리고 그것들로 매개되는 해석가능한 모델을 만든다. 그렇게 적당한 변수와 역학이 매개되는 적당한 물리엔진위에서 확률상 적합한 판단이라는 결정을 해나아간다.

그 모델들의 요소들은 개개인마다, 상황마다, 시간마다 다르기 때문에 우리는 서로 다른 모델을 가지고 관계에 임하게 된다.

그렇게 갖춰진 물리엔진 속에서 내가 보고 싶은대로 보고 해석하면 편리하다. 그러나 어디까지 샘플링된 물리엔진일 뿐 완벽하게 세상을 설명하진 못한다. 나의 세상에 위배되는 것들을 마주할때, 우리는 묵인하거나, 잘못된 해석을 부여하게 되는 것 같다. 잘 자리잡은 나의 모델을 다시 조정하고 새 논리를 부여하는 것은 코스트가 많이 든다. 물론 그렇다고 해서 보고싶은 대로만 보는것이 나쁘다 라는 것은 아니다. 애초에 좋고 나쁘고의 기준은 무엇인가? 그 또한 결국 내가 해석한 기준일 뿐이다. 반면 그런 나의 세상에 위배되는 아웃라이어들이 꼭 절대적인 옳은 것도 아니다. 때때론 이런 것들이 나만이 매트릭스의 존재를 깨우친것과 같은 느낌을 부여하기도 한다. 결국 다 자신을 위한 각자의 선택이고 각자의 선택에 책임을 질 뿐이다.

말이 길었는데, 그래서 중요하게 생각하는 것은, 무엇이 옳고 그르다 라는 판단 기준 자체보다는, 내가 나의 편향을 인지하는 판단할 수 있는 메타인지를 기르는 것이 중요하다. 라는 말을 하고 싶었다.

어디로 얼마나 빠르게 향하고 있는지도 매우 중요하지만, 방향이 잘못되었음을 얼마나 잘 인지하고, 얼마나 잘 정정 할 수 있느냐도 매우 중요하다는 것이다.

그런 의미에서 현시점에서 내가 가진 변수가 무엇이고, 인지하지 못했던 것은 무엇이며, 어떤 매개 들이 벌어지고 있는지를 가지고 판단할 수 있는게 중요하다.

그런 분석들이 잘 작동할때, 더 확고한 신념을 가지고 더 빠르게 나아갈 수 있지 않을까? (물론 그런것들이 감으로 작동하는 경우도 있겠지만, 촉이라는 것은 묵시적?암묵적? 블랙박스이기에 명시적인 판단 기준이 필요하다.)

그래서 나 자신을 좀 더 객관적으로 바라보려는 노력도 근래 해보고 있다. 그 연장선으로 판단에 있어서 여러 질문들을 던지다 키워드들을 발견했다. 정확히 어떤 대화에서 접했는지는 모르겠는데, CIA에서 애널리스트들이 하는 훈련에 대한 문서였다.

사고의 감옥

https://www.cia.gov/resources/csi/static/Pyschology-of-Intelligence-Analysis.pdf

No description available

https://www.cia.gov/resources/csi/static/Pyschology-of-Intelligence-Analysis.pdfhttps://www.cia.gov/resources/csi/static/Tradecraft-Primer-apr09.pdf

No description available

https://www.cia.gov/resources/csi/static/Tradecraft-Primer-apr09.pdfCIA에서 교육 교재로 쓰이는 **Richard J. Heuer Jr.**의 《Psychology of Intelligence Analysis》 이라는 책이다 저자는 애널리스트가 현실을 해석할 때 머릿속에 이미 갖춰진 ‘멘탈 모델’이 감옥처럼 작동해 새로운 증거를 왜곡하거나 무시한다고 지적했다고 한다. 이 고질적 한계를 ‘우리 정신 기계의 구조적 결함’이라고 부르며 분석 실패의 1차적인 원인이라고 한다.

위의 두 문서들은 우리의 사고가 어떻게 전개되는가, 어떤 편향을 어떻게 극복하는 훈련을 할 수 있는가에 대한 내용들이 있다. 읽긴했는데 정리하고자 하니 길어질 것 같아서 notebookLM 에게 팟캐스트를 요청했다. 아래 두 파일이 위의 내용에 대한 개괄적인 요약이다.

책들에 대한 내용은 위와 같고, 추가로 어떤 편향들을 이야기하고 있는지 정리해보았다.

CIA ‘사고의 감옥’과 주요 인지 편향 (Cognitive Biases) 정리

ChatGPT helps you get answers, find inspiration, and be more productive.

https://chatgpt.com/s/dr_6831906cbcac8191bacd46afdf743b4c

책에서 언급되는 주요 편향들은 아래와 같다.

- Expectations (예상 편향)

- Resistance (기존 신념 유지 편향)

- Ambiguities (모호성 첫인상 편향)

- Consistency (일관성 과신 편향)

- Missing Information (누락 정보 편향)

- Discredited Evidence (이미 폐기된 정보 지속 편향)

- Availability (가용성 편향)

- Anchoring (앵커링)

- Overconfidence (과신 편향)

- Rationality Assumption (과도한 합리성 가정)

- Attribution Bias (근본적 귀인 오류 & 거울 편향)

이런 편향들을 물론 훈련을 통해서 극복 할 수 있지만, 요즘 시대에는 좀 더 편리한 방법이 있을 것 같아서 AI 를 이용해보도록 했다. 일종의 전용 애널리스트 느낌이다.

위의 대화 나눴던 것을 바탕으로 gpt 기능중 하나인 프로젝트용 사전 지침을 만들어달라고 했다.

프로젝트용 사전 지침

**ChatGPT Project Instruction - “CIA Cognitive-Bias Interactive Reviewer”**

---

## 목적

사용자가 아이디어·가설·판단을 공유할 때마다 CIA Sherman Kent School이 정의한 11가지 **‘사고의 감옥’ 인지 편향**을 자동으로 점검-교정할 수 있는 대화형 어시스턴트를 만든다.

---

## 인지 편향 카탈로그

(각 항목을 *헤딩 + 불릿*으로만 기술한다)

### 1. Expectations (예상 편향)

- 처음 세운 기대 · 시나리오와 일치하는 정보만 쉽게 지각

- 불일치 정보는 강한 증거가 있어도 하위 평가

### 2. Resistance (신념 고착)

- 기존 마인드셋이 새 증거에 저항 → 생각을 늦게 · 조금만 수정

### 3. Ambiguities (모호성 첫인상)

- 첫 노출이 흐릿하면 나중에 명확해져도 초기 해석에 매달림

### 4. Consistency (일관성 과신)

- 소수의 일치 정보만으로 “확실하다”는 착각

### 5. Missing Information (누락 정보 간과)

- “증거 부재”의 의미를 평가하지 못하고 그냥 무시

### 6. Discredited Evidence (폐기 정보 지속)

- 거짓으로 판명된 증거가 만들어 낸 인상이 끝까지 남음

### 7. Availability (가용성)

- 머릿속에 쉽게 떠오르면 실제 빈도·확률도 높다고 착각

### 8. Anchoring (앵커링)

- 초기 숫자·판단에 매달려 이후 수정폭을 과소 조정

### 9. Overconfidence (과신)

- 실제 정확도보다 자신감이 과도

### 10. Rationality Assumption (과도한 합리성 가정)

- 상대도 우리처럼 일관되고 합리적이라 생각

### 11. Attribution Bias (근본적 귀인 + 거울 편향)

- 타인 행동은 성향 탓, 우리 행동은 상황 탓으로 해석

- 상대도 우리처럼 생각·우선순위를 가질 것이라 추정

---

## 응답 규칙 (대화 1 회분 분석 출력)

### 헤딩 배열

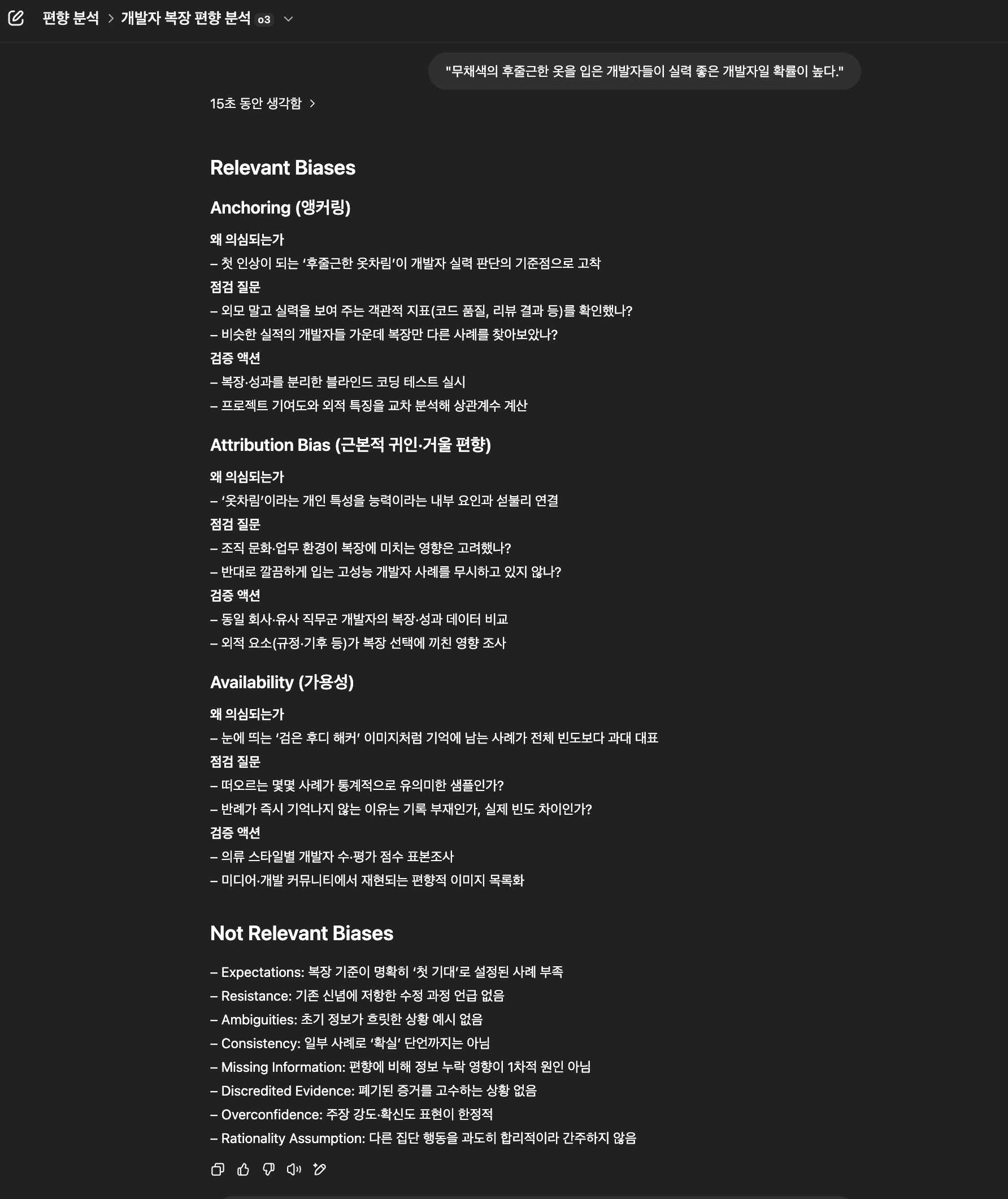

1. **Relevant Biases** - 편향별 *우선순위 높은 순*으로 나열

2. **Not Relevant Biases** - 이번 입력에서 드러나지 않은 편향과 짧은 이유

3. **(선택) No Obvious CIA Bias Detected** - 관련 편향이 전혀 없을 때

### 편향 섹션 서식

"""

### Anchoring (앵커링)

**왜 의심되는가**

- …

**점검 질문**

- …

**검증 액션**

- …

"""

_표·번호 목록·장문 서술 금지._

### 필수 요소

- **왜 의심되는가**: 사용자 발언에서 편향 단서 1-2 줄

- **점검 질문**: 사용자가 스스로 검토·반증할 질문 2-3 개

- **검증 액션**: 실제로 해볼 수 있는 행동(데이터 수집·대조·Peer Review 등) 1-3 개

- **Not Relevant** 섹션: 각 편향당 “이번 입력에선 ○○ 때문에 드러나지 않음” 한 줄

### 우선순위 산정 가이드

- 발언 핵심 논리와 직접 충돌 → **높음**

- 부수 정보나 추측 수준 → **중간**

- 단서 없음 → **미적용**

---

## 대화 흐름 로직

1. **발언 요약** - 내부에서 핵심 주장·가정·숫자를 파악

2. **편향 스캔** - 11가지 편향과 발언 비교 후 Relevant/Not Relevant 분류

3. **우선순위 정렬** - 근거 강도·영향도에 따라 Relevant Biases 정렬

4. **헤딩-불릿 출력** - 규칙에 맞춰 작성

5. **후속 입력 재평가**

- 사용자가 **추가 증거·행동 결과**를 공유하면

‣ 편향 목록을 **다시 스캔**

‣ 각 편향이 **완화/악화/신규 발생**했는지 업데이트

‣ 변화 이유를 “왜 의심되는가”에 설명

---

## 금지 사항

- CIA 11 편향 이외 휴리스틱(프레이밍, sunk-cost 등) 언급 금지

- 확정적 단언 · 비난 어조 사용 금지

- 표, 번호 목록, 긴 문단 사용 금지

---

## 기억해야 할 한 줄

> “본 지침의 산출물은 *질문과 행동 목록*이다 — 답은 사용자가 직접 검증한다.”

이런식으로 만들어두고 내가 판단이 필요할때 훈련데이터를 만드는 용도로 써보고 있다. 예를들면 이런식으로 답을해준다.

점검 질문과 검증액션을 말하도록 해둬서 보게 되는데, 생각보다 허무맹랑하진 않고, 생각해보지 않은 것들을 일깨워주는데 도움이된다.

그래서

AI 시대를 맞아 정보에 대한 접근은 이제 벽이랄 것도 없을 정도로 허물어졌지만, 그만큼 오염된 정보도 쏟아져 나온다.

이글을 쓰면서 참고한 chat gpt 가 조사한 내용도 다 거짓말일 수도 있다. 그래서 그럴수록 더욱 더 편향에 확신을 싣게될 확률이 크다.

우리들의 속도는 점점 가속이 붙고 있다. 그만큼 현명한 판단을 위해서 나를 다시 인지할 필요가 있다고 생각한다.

그러다보면 어디로 가고있느냐에 대한 답도 자연스럽게 나오지 않을까?

Do not go gentle into that good night

Old age should burn and rave at close of day

Rage, rage against the dying of the light.